Vorgehen

Der sogenannte „Cross-Industry Standard Process for Data Mining“ (CRISP-DM) hat sich als Standard-Vorgehensmodell für Data-Analytics-Projekte etabliert (Haneke et al. 2018, S. 9 f.) und wird aufgrund seiner agilen und iterativen Vorgehensweise als Grundlage und Orientierung im vorgestellten Projekt dienen.

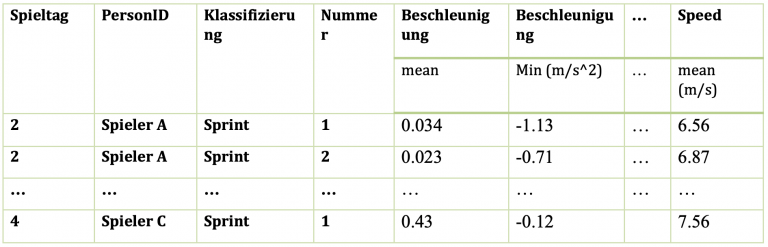

Zu Beginn eines Data-Mining Projektes steht im CRISP-DM Modell das Business Understanding. Konkret galt es in diesem Projektumfeld die sportwissenschaftlichen Fragestellungen und Zusammenhänge zu verstehen. Dafür habe ich mich Fragen wie „Wann ist eine Bewegung ein Sprint?“, „Welche Schwellwerte bezüglich Dauer, Geschwindigkeit oder Beschleunigung müssen erreicht werden?“ oder „Welche Auswirkung hat die Ausgangssituation auf die aktuelle Aktion?“ gewidmet und versucht diese zu beantworten und in das Projekt einzubetten. Parallel dazu habe ich in einer explorativen Datenanalyse ein erstes Verständnis für die Daten entwickelt und in Kombination mit den Erkenntnissen aus der Sportwissenschaft wurde klar, dass auf Basis der aktuellen Form von roh vorliegenden Positionsdaten keine Bewegungsprofile erstellt werden können. Um der Zielsetzung einen weiteren Schritt näher zu kommen und um genauere Aussagen über Bewegungs- und Beschleunigungsprofile treffen zu können, musste ich als nächstes die einzelnen Sprints und Aktionen aus der großen Menge an Positionsdaten extrahieren und separieren. Dafür habe ich in der Programmiersprache python Algorithmen entwickelt, welche die Positionsdaten durchlaufen und als Ergebnis die markierten Aktionen mit ihrer Bezeichnung und Nummerierung ausgeben. Dafür konnte ich meinem Algorithmus mehrere Parameter übergeben, welche beschreiben ab welchen Schwellwerten bezüglich Geschwindigkeit und Dauer der Aktion von einem Sprint ausgegangen werden kann.

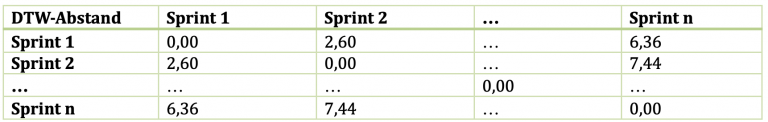

Die gefundenen Bewegungen werden nun genauer analysiert und in einem ersten Versuch miteinander verglichen. Da es sich bei den betrachteten Sprints um Zeitreihen handelt, kommen direkt eine Vielzahl an Merkmalen in Betracht, in welchen Dimensionen die Sprints sich voneinander unterscheiden oder Gemeinsamkeiten aufweisen können. Angefangen von der Dauer der Aktion, dem Verlauf des Sprints mit Hoch- und Tiefpunkten, die maximal erreichte Geschwindigkeit oder auch die Ausgangssituation des Sprints. Dabei kann zwischen verschiedenen Laufgeschwindigkeiten unterschieden werden, angefangen von „aus dem Stand“ bis hin zu „aus dem Joggen“. Je nach Ausgangssituation ist eine unterschiedlich hohe maximale Beschleunigung möglich und die Intensität der Bewegung kann daher nicht auf dem Vergleich von absoluten Werten bemessen werden.

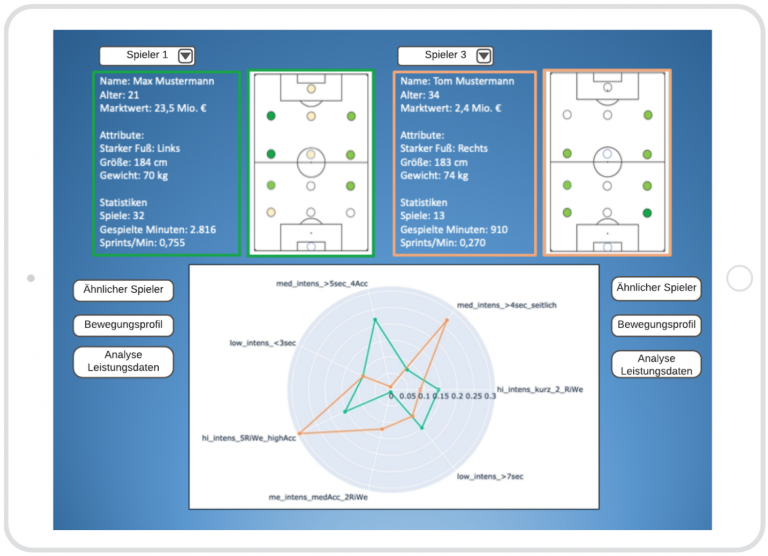

Um mich dem Projektziel weiter anzunähern, in dem ich Spieler in Cluster ähnlicher Spieler einteilen und Spielerprofile bezüglich ihrer Bewegungsfähigkeiten erstellen will, werden im nächsten Schritt zuerst die extrahierten Bewegungen in Cluster ähnlicher Bewegungen eingeteilt. Aufbauend auf dem Cluster-Modell der Bewegungen werden dann Spielerprofile aufgrund der Verteilung ihrer Sprints in genau diese Bewegungs-Cluster erstellt.

Aber jetzt zuerst zum Cluster-Modell der Bewegungen. Ziel dieser Modellbildung ist die Einteilung der gefundenen Sprints in Cluster mit ähnlichen Bewegungen und Bewegungsverläufen. Die Sprints eines Spielers sollen in möglichst wenigen verschiedenen Clustern vorkommen. Diese Zielsetzung ermöglicht es im nächsten Schritt explizit Spieler- und Beschleunigungsprofile zu erstellen und auszuwerten. Um die programmierten Modelle miteinander zu vergleichen und zu bewerten, habe ich zu Beginn zwei Bewertungskriterien für dieses Projekt bestimmt. Zur Bewertung der Qualität eines Clusters gibt es zwei Arten von anwendbaren Methoden. Besteht im Vorfeld die Information über ein ideales Clustering oder die perfekte korrekte Zuordnung, werden extrinsische Methoden (auch: überwachte Methoden) angewendet. Dabei wird das erstellte Clustering-Modell mit der idealen Zuordnung verglichen. Ein solches ideales Clustering wird meistens mit Hilfe menschlicher Experten erstellt, indem jedem Objekt ein Cluster-Label zugeordnet wird. Ist diese Information über ein ideales Cluster nicht gegeben, werden intrinsische Methoden (auch: unüberwachte Methoden) angewendet, welche die Güte auf Basis der Trennung der Cluster bewerten (Han et al. 2011, S. 487).

Im Rahmen dieses Projektes habe ich je einen intrinsischen und einen extrinsischen Parameter zur Bestimmung der Modell-Güte angewendet.:

Die extrinsische Methode der Entropie (engl.: Entropy) beschreibt das Maß, zu dem jedes Cluster aus Objekten einer einzigen Klasse besteht. Angewendet auf die Umstände dieses Projektes bedeutet das, dass eine niedrige Entropie genau dann vorliegt, wenn die Sprints eines Spielers in möglichst wenigen verschiedenen Clustern auftauchen. Eine hohe Entropie liegt hingegen vor, wenn in einem Cluster Sprints von nahezu jedem Spieler des Datensatzes enthalten sind.

Die intrinsische Methode des Silhouetten Koeffizienten beschreibt die Qualität der Zuordnung der Objekte zu den Clustern. Es wird gemessen wie gut die Cluster voneinander getrennt sind und wie geschlossen ein Cluster an sich ist.

Viele Clustering-Algorithmen benötigen als Eingabeparameter eine vordefinierte Anzahl an Clustern. Die Bestimmung dieser Menge an Clustern ist jedoch zu Beginn eine große Herausforderung und nicht immer eindeutig zu lösen. Mit Hilfe der intrinsischen Methode des Ellenbogenkriteriums lassen sich oft gute Größen für die Anzahl an Clustern bestimmen. Dazu werden die Verzerrungen, also die quadrierten Abweichungen innerhalb des Clusters, summiert und für verschiedene Werte für k (k= Anzahl an Cluster) berechnet (Raschka und Mirjalili 2018, S. 362 f. und Tan et al. 2005, S. 546 f.). Die Idee des Ellenbogenkriteriums ist es, denjenigen Wert k mit der größten Veränderung der Verzerrung zu finden. In diesem Beispiel in der nebenstehenden Abbildung liegt dieser Punkt bei k=5. Bei der Modellbildung zur Clusteranalyse in den kommenden Schritten habe ich genau dieses Ellenbogenkriterium verwendet, um die Anzahl an zu suchenden Clustern k zu bestimmen.